/cdn.vox-cdn.com/uploads/chorus_asset/file/22512650/acastro_210512_1777_deepfake_0002.jpg)

عندما توصل المشرعون الأوروبيون إلى اتفاق مؤقت بشأن قواعد الذكاء الاصطناعي التاريخية الأسبوع الماضي، كان لديهم سبب للاحتفال.

تم التوصل إلى قانون الاتحاد الأوروبي بشأن الذكاء الاصطناعي الذروة التي طال انتظارها يوم الجمعة وذلك بعد عامين من المناقشة الواسعة النطاق، بل وأيضاً بعد مناقشة “ماراثونية” دامت ثلاثة أيام بين المفوضية الأوروبية، والبرلمان الأوروبي، والدول الأعضاء في الاتحاد الأوروبي لتسوية الخلافات. تم سحب كل الليل. صناديق فاضت مع بقايا القهوة ومشروبات الطاقة والوجبات الخفيفة السكرية. لقد كانت تلك هي البيئة التي تتوقعها من الطلاب الذين يستعدون للامتحانات النهائية، وليس المشرعين الذين يعملون على التشريعات التي يمكن أن تضع مخططًا لتنظيم الذكاء الاصطناعي العالمي. ترجع الفوضى إلى حد كبير إلى قضيتين مثيرتين للجدل هددت بإخراج المفاوضات بأكملها عن مسارها: التعرف على الوجه ونماذج “الأساس” القوية.

عندما تم اقتراح قانون الذكاء الاصطناعي لأول مرة في أبريل 2021وكان الهدف منها مكافحة “المخاطر الجديدة أو العواقب السلبية على الأفراد أو المجتمع” التي يمكن أن يسببها الذكاء الاصطناعي. ركز القانون على الأدوات التي تم نشرها بالفعل في مجالات مثل الشرطة والتوظيف والتعليم. ولكن على الرغم من أن الهدف العام لمشروع القانون لم يتغير، إلا أن تكنولوجيا الذكاء الاصطناعي فعل – وبسرعة. كانت القواعد المقترحة غير مجهزة للتعامل مع الأنظمة ذات الأغراض العامة التي يطلق عليها على نطاق واسع النماذج الأساسية، مثل التكنولوجيا التي تقوم عليها ChatGPT ذات الشعبية الكبيرة من OpenAI، والتي تم إطلاقها في نوفمبر 2022.

ينبع جزء كبير من التأخير في اللحظة الأخيرة من سعي صناع السياسات لضمان أن تقنيات الذكاء الاصطناعي الجديدة – بالإضافة إلى التقنيات المستقبلية التي لم يتم تطويرها بعد – تقع ضمن نطاق التشريع. وبدلاً من مجرد تنظيم كل مجال قد يظهرون فيه (قائمة تشمل السيارات والألعاب والأجهزة الطبية وغير ذلك الكثير)، استخدم القانون نظام الطبقة الذي يصنف تطبيقات الذكاء الاصطناعي على أساس المخاطر. خضعت أنظمة الذكاء الاصطناعي “عالية المخاطر” التي يمكن أن تؤثر على السلامة أو الحقوق الأساسية إلى القيود التنظيمية الأكثر صرامة. علاوة على ذلك، واجهت أنظمة الذكاء الاصطناعي للأغراض العامة (GPAI) مثل نماذج GPT الخاصة بشركة OpenAI لوائح إضافية. وكانت المخاطر المرتبطة بهذا التصنيف عالية، وبالتالي كان الجدل حوله حادا.

يقول دانييل لوفر، كبير محللي السياسات في منظمة Access Now، وهي منظمة رقمية لحقوق الإنسان: “في مرحلة ما، بدا الأمر وكأن التوترات حول كيفية تنظيم GPAI يمكن أن تعرقل عملية التفاوض برمتها”. “كان هناك ضغط كبير من فرنسا وألمانيا وإيطاليا لاستبعاد هذه الأنظمة تمامًا من أي التزامات بموجب قانون الذكاء الاصطناعي”.

سعت فرنسا وألمانيا وإيطاليا إلى التوصل إلى حلول وسط في اللحظة الأخيرة لنماذج الذكاء الاصطناعي الأساسية

تلك البلدان، الثلاثة من أكبر الاقتصادات في أوروبا، بدأت المفاوضات المتعثرة في نوفمبر بسبب مخاوف من أن القيود الصارمة قد تفعل ذلك الحد من الابتكار والإضرار بالشركات الناشئة التي تعمل على تطوير نماذج الذكاء الاصطناعي التأسيسية في ولاياتها القضائية. وتعارضت هذه المخاوف مع مشرعين آخرين في الاتحاد الأوروبي سعوا إلى فرض لوائح تنظيمية صارمة بشأن كيفية استخدامها وتطويرها. وقد ساهمت هذه المشكلة التي ألقيت في اللحظة الأخيرة في مفاوضات قانون الذكاء الاصطناعي في تأخير التوصل إلى اتفاق، لكنها لم تكن النقطة الشائكة الوحيدة.

في الواقع، يبدو أن قدرًا كبيرًا من التشريع الفعلي ظل غير مستقر حتى قبل أيام من إبرام الصفقة المؤقتة. خلال اجتماع بين وزراء الاتصالات والنقل الأوروبيين في 5 ديسمبروقال وزير الرقمية الألماني فولكر فيسينج إن “تنظيم الذكاء الاصطناعي ككل ليس ناضجًا تمامًا بعد”.

واجهت أنظمة GPAI متطلبات مثل الكشف عن بيانات التدريب، واستهلاك الطاقة، والحوادث الأمنية، فضلاً عن إخضاعها لتقييمات مخاطر إضافية. ومن غير المستغرب أن تقوم شركة OpenAI (الشركة المعروفة برفضها الكشف عن تفاصيل حول عملها)، جوجل، و مايكروسوفت ضغطت على الاتحاد الأوروبي لتخفيف اللوائح الأكثر صرامة. ويبدو أن تلك المحاولات أتت بثمارها. بينما سبق أن نظر المشرعون في التصنيف الجميع إن GPAIs باعتبارها “عالية المخاطر”، فإن الاتفاقية التي تم التوصل إليها الأسبوع الماضي تُخضعها بدلاً من ذلك لنظام من مستويين يسمح للشركات ببعض المساحة للمناورة لتجنب أقسى قيود قانون الذكاء الاصطناعي. هذا ايضا، من المحتمل أن يكون قد ساهم في تأخيرات اللحظة الأخيرة تم تجزئته في بروكسل الأسبوع الماضي.

يقول لوفر: “في النهاية، حصلنا على الحد الأدنى جدًا من التزامات الشفافية لأنظمة GPAI، مع بعض المتطلبات الإضافية لما يسمى بأنظمة GPAI “عالية التأثير” التي تشكل “خطرًا نظاميًا”، ولكن لا تزال هناك “معركة طويلة” قدما للتأكد من أن الرقابة على هذه التدابير وتنفيذها تعمل بشكل صحيح.

هناك فئة أكثر صرامة أيضا: الأنظمة ذات مستوى المخاطر “غير المقبول”، والتي يحظرها قانون الذكاء الاصطناعي بشكل كامل. وفي المفاوضات حتى الساعات الأخيرة، كانت الدول الأعضاء كذلك لا يزال السجال أكثر وما إذا كان ينبغي أن يشمل ذلك بعض أدوات المراقبة عالية التقنية الأكثر إثارة للجدل.

كان الحظر التام على أنظمة الذكاء الاصطناعي للتعرف على الوجه موضع معارضة شديدة

البرلمان الأوروبي في البداية أعطت الضوء الأخضر لفرض حظر كامل على أنظمة القياسات الحيوية للمراقبة العامة الجماعية في يوليو. وشمل ذلك إنشاء قواعد بيانات للتعرف على الوجه عن طريق استخراج البيانات بشكل عشوائي من وسائل التواصل الاجتماعي أو لقطات كاميرات المراقبة؛ أنظمة الشرطة التنبؤية بناءً على الموقع والسلوك السابق؛ والتصنيف البيومتري على أساس الخصائص الحساسة مثل العرق والدين والعرق والجنس والمواطنة والانتماء السياسي. كما حظرت أيضًا تحديد الهوية البيومترية عن بعد في الوقت الفعلي وبأثر رجعي، مع الاستثناء الوحيد وهو السماح لإنفاذ القانون باستخدام أنظمة التعرف المتأخر لملاحقة “الجرائم الخطيرة” بعد موافقة قضائية. المفوضية الأوروبية والدول الأعضاء في الاتحاد الأوروبي اعترض عليه وحصلت على تنازلات – للبعض ذعر النقاد.

تتضمن المسودة التي تمت الموافقة عليها يوم الجمعة استثناءات تسمح بالاستخدام المحدود للتعرف الآلي على الوجه، مثل الحالات التي يتم فيها تحديد الهوية بعد تأخير كبير. وقد تتم الموافقة عليه أيضًا لحالات استخدام محددة لإنفاذ القانون تنطوي على تهديدات للأمن القومي، ولكن فقط في ظل ظروف معينة (غير محددة حاليًا). ومن المحتمل أن يكون ذلك بمثابة استرضاء لأعضاء الكتلة مثل فرنسا، التي دفعت لاستخدام المراقبة بمساعدة الذكاء الاصطناعي مراقبة أشياء مثل الإرهاب والقادمة دورة الالعاب الاولمبية 2024 في باريسلكن منظمات حقوق الإنسان مثل منظمة العفو الدولية كانت أكثر انتقاداً لهذا القرار.

“من المخيب للآمال أن نرى البرلمان الأوروبي يستسلم لضغوط الدول الأعضاء للتراجع عن موقفه الأصلي”. قال مهير هاكوبيان، مستشار المناصرة بشأن تنظيم الذكاء الاصطناعي في منظمة العفو الدولية. “بينما يجادل المؤيدون بأن المسودة تسمح فقط بالاستخدام المحدود للتعرف على الوجه وتخضع للضمانات، فإن البحث الذي أجرته منظمة العفو الدولية في مدينة نيويورك، الأراضي الفلسطينية المحتلة, حيدر أباد، وفي أماكن أخرى يوضح أنه لا توجد ضمانات يمكن أن تمنع الأضرار التي تلحقها تقنية التعرف على الوجه بحقوق الإنسان، ولهذا السبب هناك حاجة إلى فرض حظر تام.

ولجعل الأمور أكثر تعقيدًا، لا يمكننا الخوض في أي منها محدد تم التوصل إلى تنازلات، لأن النص الكامل لقانون الذكاء الاصطناعي المعتمد لن يكون متاحًا قبل عدة أسابيع. من الناحية الفنية، ربما لا توجد رسميًا داخل الاتحاد الأوروبي حتى الآن على الاطلاق. يقول إن التنازلات بشأن هذه الاتفاقيات غالبًا ما تعتمد على المبادئ وليس على الصياغة الدقيقة مايكل فيل، أستاذ مشارك في الحقوق الرقمية والتنظيم في كلية الحقوق بجامعة كاليفورنيا. وهذا يعني أن الأمر قد يستغرق بعض الوقت حتى يتمكن المشرعون من تحسين اللغة القانونية.

وأيضًا، نظرًا لأنه تم التوصل إلى اتفاق مؤقت فقط، فإن التشريع النهائي لا يزال عرضة للتغيير. لا يوجد جدول زمني رسمي متاح، ولكن يبدو أن خبراء السياسة متفقون إلى حد ما على تقديراتهم: من المتوقع أن يصبح قانون الذكاء الاصطناعي قانونًا بحلول منتصف عام 2024 بعد نشره في الجريدة الرسمية للاتحاد الأوروبي، مع دخول جميع الأحكام حيز التنفيذ تدريجيًا على مدار العامين المقبلين.

وهذا يمنح صناع السياسات بعض الوقت للتوصل إلى كيفية تنفيذ هذه القواعد بالضبط. يمكن لشركات الذكاء الاصطناعي أيضًا استخدام هذا الوقت للتأكد من أن منتجاتها وخدماتها متوافقة مع القواعد عندما تدخل الأحكام حيز التنفيذ. في النهاية، هذا يعني أننا قد لا نرى كل شيء ضمن قانون الذكاء الاصطناعي منظمًا حتى منتصف عام 2026. في سنوات تطوير الذكاء الاصطناعي، هذا هو منذ وقت طويل – بحلول ذلك الوقت، قد يكون لدينا مجموعة جديدة كاملة من القضايا للتعامل معها.

. “Coffeeaholic. متعصب للكحول مدى الحياة. خبير سفر نموذجي. عرضة لنوبات اللامبالاة. رائد الإنترنت.”

More Stories

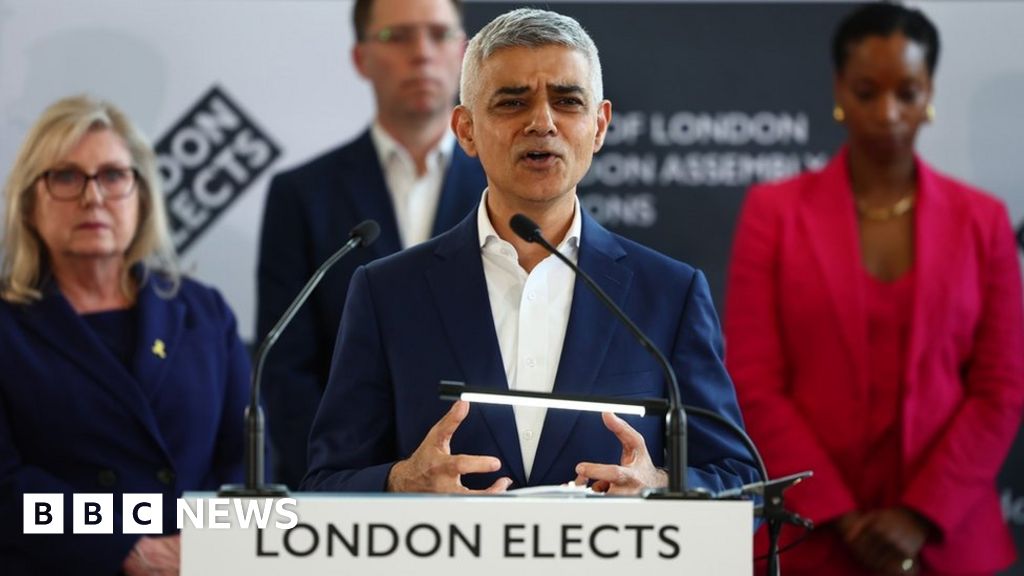

انتخابات عمدة لندن: صادق خان يفوز بولاية ثالثة تاريخية

الآمال في وقف إطلاق النار في غزة تتزايد مع وصول وفد حماس إلى القاهرة | حرب إسرائيل وغزة

المحافظون في المملكة المتحدة يتكبدون خسائر تاريخية في الانتخابات المحلية – DW – 05/04/2024